Egal in welcher Branche man sich heute umhört – der Begriff „Cloud“ und „Daten auslagern“ ist allgegenwärtig. Es scheint die Lösung für alle Probleme zu sein – ohne Rücksicht auf Konsequenzen. Aber ist das wirklich so?

Die Nutzung einer Cloud ist selbstverständlich geworden. Egal ob Google, Dropbox, Microsoft oder wie sie sonst noch heissen – fast jeder lagert bei einem dieser grossen Anbieter einen Teil seiner Daten.

Der Grund dafür? Nun – Daten in der Cloud zu lagern ist einfach ungemein praktisch. Weder muss man sich um ein Backup kümmern, noch müssen die Daten in irgendeiner Form mit sich geführt werden. Selbst unterwegs hat man vollen Zugriff auf wichtige Informationen und kann diese nach Belieben mit allen teilen.

Der Grund dafür? Nun – Daten in der Cloud zu lagern ist einfach ungemein praktisch. Weder muss man sich um ein Backup kümmern, noch müssen die Daten in irgendeiner Form mit sich geführt werden. Selbst unterwegs hat man vollen Zugriff auf wichtige Informationen und kann diese nach Belieben mit allen teilen.

Hinzu kommen die verhältnismässig geringen Kosten die bei den grossen Cloudanbietern teilweise sogar ganz entfallen.

Doch gibt es dabei keinen Haken? Keine Hintergedanken?

Alles hat seinen Preis

Alles hat seinen Preis, auch Dinge, von denen man sich einbildet, man kriegt sie geschenkt.

Jeder weiss es, nicht immer ist man sich dessen aber bewusst. (Nur) Nichts ist gratis.

Selbstverständlich bezahlt man beispielsweise für OpenSource Produkte die man kostenlos herunterladen kann nicht mit Geld – dafür aber mit Zeit, die man braucht um sich damit vertraut zu machen.

Auch bei Demoversionen und Gratisproben bezahlen wir mit Zeit – die wir einsetzen um uns mit dem Produkt zu befassen.

Wo also liegt der Preis der Cloud?

In der Zeit? In den meisten Fällen nicht – den Cloudprodukte sind praktisch „idiotensicher“ aufgebaut. Ein paar Klicks dort, ein paar Klicks da – und komplexe Vorgänge sind plötzlich auch für Neueinsteiger möglich.

Für viele alltägliche Probleme finden sich heute findige Cloudprovider die eine Lösung anbieten – was darunter leidet ist das Verständnis und die Möglichkeit sich selbst weiterzuentwickeln.

All dies führt zu einer starken Abhängigkeit vom jeweiligen Anbieter. Man mag argumentieren, dass gerade im IT-Bereich immer eine Abhängigkeit von Systemen oder Produkten vorhanden ist – doch in der Cloud ist diese wesentlich stärker, da die Daten nicht nur technisch sondern auch räumlich vom Benutzer abgetrennt werden.

Ein Beispiel? Bei einer Serverlösung im Büro wissen Sie, dass Ihre Daten in Griffweite liegen. Bei einer Cloudlösung hingegen wissen Sie – …nichts.

Ihre Daten könnten theoretisch überall auf der Welt verteilt liegen, das Dokument XY liegt in einem Rechenzentrum in den USA, Video Y liegt auf einem Server in Deutschland…

Kurzum – wenn Sie totale Abhängigkeit suchen, in der Cloud werden Sie fündig!

Verblendung

Die monetären Kosten eine Cloudlösung versperren uns die Sicht auf den wahren Preis.

Es beginnt bereits im kleinen.

Sätze wie „Sichern Sie sich jetzt 5 GB kostenlosen Speicherplatz“ oder „Lager Sie Ihre Daten jetzt sicher und kostenlos in der Cloud“ klingen gut und verleiten uns, dieses Angebot gleich zu nutzen – denn was kann schon passieren?

Das wir dabei nicht nur unser Benutzerverhalten sondern auch unsere persönlichen Daten offenlegen spielt kurzfristig keine Rolle – denn das Angebot ist ja einfach „zu gut“…

Dasselbe gilt für jede andere virtuelle Dienstleistung; E-Mail, Dokumentenbearbeitung, Musik– alles bekommt man heute in der Cloud – günstiger oder kostenlos und überall verfügbar!

Das Problem dabei, ist nicht einmal die Suche nach dem „günstigsten“ (oder billigsten?) Anbieter, denn jeder hat das Recht für sich oder sein Unternehmen das günstigste Angebot zu wählen. Problematisch ist ist die „Geiz-ist-geil“ Mentalität; Wir fahren 20 km weiter, weil die Tankstelle dort das Benzin 2 Rappen günstiger anbietet. Wir bestellen Elektronikprodukte online aus China weils 30.- Franken günstiger kommt. Wir lagern Daten in der Cloud weils günstiger oder sogar kostenlos ist. Kurz – wir ordnen sämtliche Vor- und Nachteile den monetären Kosten unter – ohne Rücksicht auf langfristige Folgen.

Wir lassen uns vom Faktor Preis (ver)blenden – auf Kosten unserer Individualität und Unabhängigkeit.

Von Vordenkern und Mitläufern

Wer eine Cloudlösung verwendet, spielt nach den Regeln seines Anbieters. Alle Prozesse und Abläufe wurden vordefiniert – es gibt wenig Platz für eigene Anpassungen. Selbstverständlich lassen sich gewisse Punkte individualisieren (Logo, Texte) – aber immer nur bis zu einem gewissen Punkt. Jemand hat für Sie vorgedacht – jetzt müssen Sie mitlaufen.

Grundsätzlich ist die Idee eines vordefinierten Systems, dass sofort produktiv eingesetzt werden kann zwar absolut in Ordnung. Problematisch ist nur die Tatsache, dass dieses System sagt, was man wie tun muss. Die Notwendigkeit sich selbst mit einem Problem zu befassen entfällt fast vollständig – damit aber auch der Lerneffekt und die Chance individuelle Abläufe zu optimieren.

Macht die Cloud dumm?

Die Frage ist heikel, muss aber dennoch gestellt werden. Wo wären wir heute, wenn die Menschheit immer nur vordefinierten Prozessen gefolgt wäre? Nur „fixfertige“ Produkte eingekauft hätte? Grundlegende Fragen einfach übergangen worden wären, weil die Lösung ja bereits da ist?

Die Frage ist heikel, muss aber dennoch gestellt werden. Wo wären wir heute, wenn die Menschheit immer nur vordefinierten Prozessen gefolgt wäre? Nur „fixfertige“ Produkte eingekauft hätte? Grundlegende Fragen einfach übergangen worden wären, weil die Lösung ja bereits da ist?

Wohin kommen wir, wenn die Antwort auf jede Frage nur noch lautet „die Cloud“?

Wo sind meine persönlichen Finanzdaten? In der Cloud.

Wo ist mein Erspartes? In der Cloud.

Woher erfahre ich, welches Wetter morgen ist? Aus der Cloud.

Woher erfahre ich den schnellsten Weg nach Zürich? Aus der Cloud.

Selbstverständlich ist die Cloud nicht durch und durch schlecht. Im Gegenteil. In gesundem Masse kann sie tatsächlich Dinge vereinfachen und Kosten senken. Doch genau dieses Mass findet bei weitem nicht jeder – inbesondere da „die Cloud“ immer mehr zum Statussymbol avanciert und Personen ohne Cloudnutzung als altmodisch oder ängstlich abstempelt.

Die Cloud kann „dumm machen“ indem uns komplexe Vorgänge als absolut simpel verkauft werden. Wir reichen ein Problem ein und erhalten die Lösung – wo, wie und womit diese aber entstanden ist bleibt unverständlich. Die Cloud denkt für uns und löst unsere Probleme, nimmt uns dabei aber auch die Gelegenheit uns selbst weiterzuentwickeln und neue Lösungswege zu finden.

Macht die Cloud abhängig?

Auf jeden Fall. Je komplexer die Cloudlösung, desto komplizierter ist der Zugriff auf Rohdaten. Bei reinen Speicherlösungen wie Dropbox, Google Drive oder Backup in der Cloud ist der Zugriff und der Erhalt von Daten noch relativ problemlos möglich. Werden hingegen ganze Systeme wie Server oder virtuelle Arbeitsplätze in der Cloud hinterlegt ist ohne Zustimmung des Anbieters oftmals nur ein teilweiser Zugriff möglich. Eine schnelle Möglichkeit den Anbieter zu wechseln gibt es dann nicht mehr – selbst der Export von simplen Datensätzen kann zu einer Herkulesaufgabe werden.

Bei jeder Entscheidung für eine Erweiterung oder Ergänzung des System muss der Anbieter miteinbezogen werden. Kann z.B. mit einer physischen Infrakstruktur, die im Büro steht recht einfach ein Benutzer oder Gerät hinzugefügt werden, fehlen Ihnen bei einer in der Cloud hinterlegten Lösung dazu meist die Berechtigungen. Sie müssen zuerst nachfragen, ob das möglich ist bzw. was das zusätzlich kostet – und sind damit wiederum abhängig vom Anbieter.

Ist die Cloud sicher?

Sicherheit wird immer wichtiger – insbesondere wenn theoretisch jeder auf die Clouddaten zugreifen kann. In diesem Punkt müssen Sie sich aber auf Ihren Cloudanbieter verlassen – Sie haben wenig Möglichkeiten die Sicherheit zu überprüfen geschweige denn zu erhöhen. Sie spielen nach den Regeln Ihres Cloudproviders und müssen sich danach richten.

Auch der gern und oft erwähnte Standortvorteil Schweiz ist kein Garant für Sicherheit. Zwar mag dadurch eine gewisse rechtliche Sicherheit gegeben sein – wie stark sich ausländische Geheimdienste aber um das Recht in der Schweiz bzw. in Europa scheren, dürfte aber hinlänglich bekannt sein. Da jede Cloudlösung auch immer einen Teil Soft- oder Hardware „Made in USA“ beeinhaltet, lässt sich auch die Gefahr für mögliche Hintertürchen nicht vollständig ausschliessen. Kurz – es ist eine Illusion zu glauben, nur weil eine Lösung in Europa gehostet wird, sei man gegen Datenschnüffelei vollständig geschützt.

Dass Sicherheit gerade im Web schnell zum Problem werden kann, zeigte beispielsweise die Sicherheitslücke „Heartbleed„. Zwar kann sie auch lokale Installationen betreffen, der Schwerpunkt wird aber bei Cloudlösungen liegen. Welche Schäden dadurch entstanden sind wird sich erst langfristig zeigen.

Weg ohne Wiederkehr?

Die Cloud ist nicht ohne Grund nach einer Wolke benannt. Zwar hat man jederzeit Zugriff auf seine Daten, auf welchem physischen Medium diese Daten dann schlussendlich aber lagern kann oft gar nicht oder nur schwer festgestellt werden – alles liegt im „Nebel der Cloud„.

Zugegeben – dies mag für Urlaubsbilder oder private Mails keine grosse Rolle spielen. Sobald aber sensible Informationen wie Passwörter, persönliche Informationen oder Geschäftsdaten gespeichert werden, ist die Frage in welchen Teilen der Welt diese Daten denn nun kursieren, sicherlich berechtigt.

Da der Weg der Daten bei Cloudlösungen nicht immer nachvollzogen werden kann, ist auch die Enfernung derselben immer mit einem gewissen Risiko behaftet. Anders ausgedrückt – was einmal in der Cloud liegt ist nur sehr schwer wieder zu entfernen.

Relativierung

Den Preis der Cloud lässt sich nicht monetär beziffern. Wir bezahlen nicht nur mit Geld sondern auch mit nur schwer messbaren Werten wie Abhängigkeit, Persönlichen Informationen und Verlust von Selbständigkeit. Gleichzeitig ist die Cloud aber auch nicht durch und durch schlecht – in vernünftigem Masse verwendet, kann sie durchaus nützlich sein und den Alltag erleichtern.

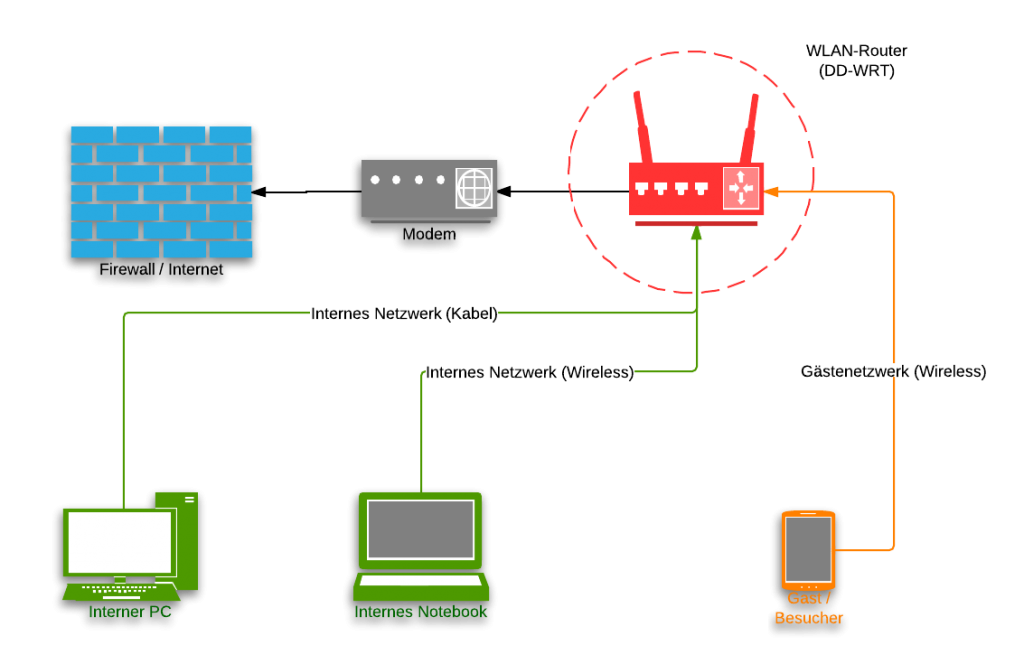

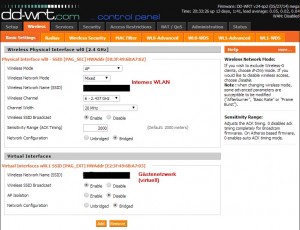

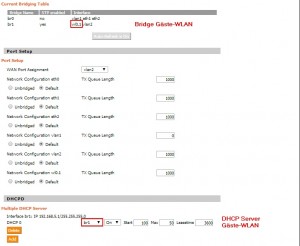

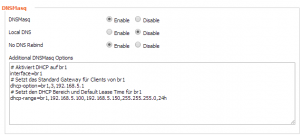

Wie so oft gibt es nicht nur schwarz und weiss (Cloud vs. Offline) sondern auch grau – z.B. in Form einer privaten Cloud oder einer ausgeglichenen Hybridlösung. Alternativen zur Cloud insbesondere im Geschäftsbereich gibt es zu Genüge – sofern man denn dem Cloud-Hype widerstehen kann…

Der Grund dafür? Nun – Daten in der Cloud zu lagern ist einfach ungemein praktisch. Weder muss man sich um ein Backup kümmern, noch müssen die Daten in irgendeiner Form mit sich geführt werden. Selbst unterwegs hat man vollen Zugriff auf wichtige Informationen und kann diese nach Belieben mit allen teilen.

Der Grund dafür? Nun – Daten in der Cloud zu lagern ist einfach ungemein praktisch. Weder muss man sich um ein Backup kümmern, noch müssen die Daten in irgendeiner Form mit sich geführt werden. Selbst unterwegs hat man vollen Zugriff auf wichtige Informationen und kann diese nach Belieben mit allen teilen.